La demande en matière de données n’a jamais été aussi forte. Et pour cause : les entreprises – toutes activités confondues – ont maintenant mesuré l’étendue des possibilités offertes par l’analyse de ces précieux renseignements. A fortiori en des temps où la connaissance du client et l’optimisation de l’expérience utilisateur constituent des enjeux majeurs pour nombre de sociétés. Quelles sont les tendances de 2021 en matière de Big Data ? Réponse ci-dessous.

Qu’est-ce que le Big Data ?

Littéralement, nous pourrions le traduire par “mégadonnées”. Ce terme un peu vague désigne ainsi une quantité massive de données, provenant de moult endroits : des SMS que nous envoyons, aux signaux GPS, en passant par notre activité sur les réseaux sociaux et les transactions que nous effectuons sur le net. La liste n’est pas exhaustive et c’est d’ailleurs pourquoi ces informations ont été regroupées sous l’appellation de “Big Data”. En vérité, il est impossible de donner une définition précise de ce concept, tant celui-ci s’avère complexe, polymorphe et sujet à diverses interprétations, en fonction du secteur qui y fait référence.

En tout état de cause, les données sont utiles pour quantité de business, et ce, à de multiples échelles : afin de les présenter à vos collaborateurs et à vos clients, afin d’élaborer de nouveaux produits et services, ou encore afin de prendre des décisions d’ordre commercial.

De surcroît, le stockage d’informations est de plus en plus abordable. Le phénomène du big data a vu le jour dans les années 1960, avec la création des tous premiers “data warehouses”. Dès lors, les choses n’ont cessé d’aller crescendo – conformément au flux de données qui n’a cessé, lui aussi, de croître. Aujourd’hui, les acteurs de l’économie savent que ces données peuvent être recueillies, grâce à de nombreux outils (plateformes et applications, par exemple). Outils logiquement devenus indispensables.

Comment fonctionne le Big Data ?

L’adoption d’un tel système d’information ne s’improvise pas. De fait, parvenir à traiter une quantité aussi conséquente de données implique une infrastructure solide et rigoureuse, telle que la solution Elipce vous permet de mettre en place.

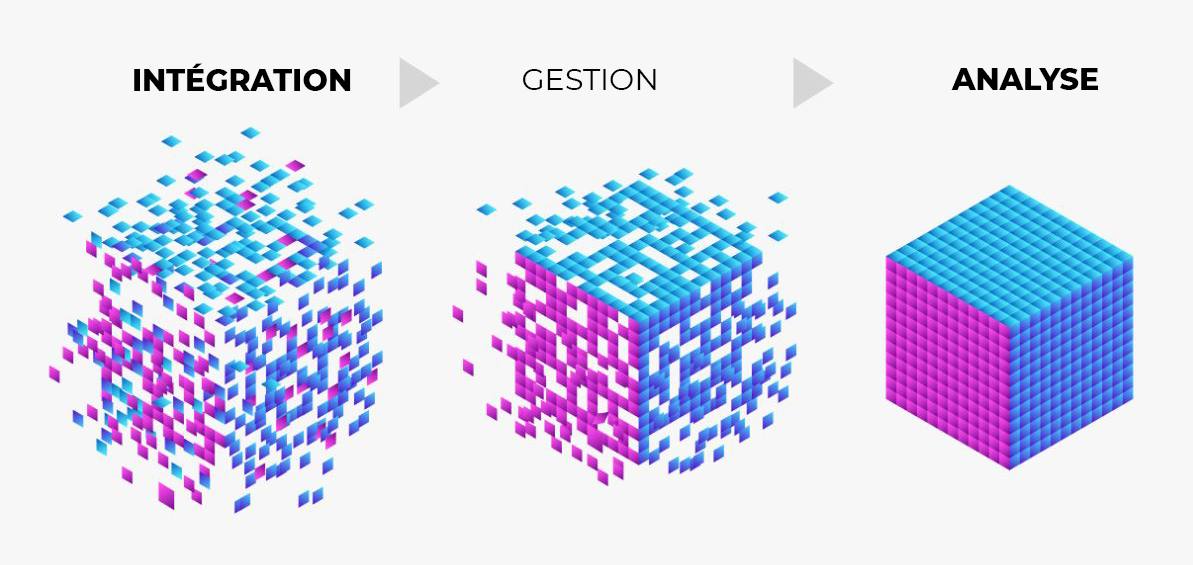

Le fonctionnement du Big Data se découpe en trois étapes distinctes.

L’intégration

Cette étape correspond à l’importation, au traitement, ainsi qu’au formatage des données. Le but : faire en sorte que ces dernières soient rendues accessibles aux analystes. Et pour cause : les sources en provenance desquelles affluent toutes ces informations sont nombreuses. D’ailleurs, les mécanismes traditionnels d’intégration de données s’avèrent le plus souvent incapables de les traiter. Pour analyser plusieurs téraoctets – voire pétaoctets – de flux, ayez à l’esprit qu’il est impératif de disposer de certaines technologies spécifiques.

La gestion

Comprenez : le stockage. Par essence, le Big Data induit la nécessité de détenir une solution de stockage. À ce sujet, les pistes sont diverses et dépendent généralement de l’endroit où sont hébergées les données. L’option du cloud est de plus en plus privilégiée, dans la mesure où celui-ci offre la possibilité d’augmenter les ressources, si la situation l’exige.

L’analyse

Autrement dit, la clef du succès. Après tout, il n’est guère utile de collecter une telle masse de données sans jamais l’analyser.

Les objectifs liés à cette exploitation peuvent – là encore – être divers : analyse de tendances, validation d’hypothèses, exploration de nouveaux segments, etc.

Pourquoi fait-on du Big Data ?

Le Big Data est source d’opportunités. En 2021, la détention de l’information est devenue un avantage majeur pour celui ou celle qui en jouit. Plus spécifiquement : un avantage concurrentiel.

En premier lieu, le Big Data permet d’optimiser l’offre existante. Grâce à une analyse poussée des attentes, puis du comportement des consommateurs, il est désormais possible de travailler son site (ou son application) en conséquence. Dans cette optique, les indicateurs au service des entreprises sont légion : nombre de visites, navigation, taux de rebond, de clic et de conversion, nombre de pages visitées, etc.

Par ailleurs, le Big Data est également un moyen d’anticiper les besoins et, par extension, la sacro-sainte demande. Il s’agit alors d’exploiter les données, afin de réaliser des analyses dites “prédictives” et d’établir différentes probabilités d’évolution. Analyse statistique, modélisation et machine learning sont autant de façons de prévoir les tendances de demain.

Enfin, le Big Data s’avère un puissant atout d’ordre logistique : utilisé en vue d’obtenir des insights pertinents, il est un conseiller de choix dans le cadre du pilotage d’une activité. En permettant la visualisation des ventes en temps réel, il devient par exemple possible d’orienter sa production en conséquence.

Les 5V du Big Data

De façon générale, on considère qu’une gestion optimisée du Big Data ne peut se faire sans prendre en considération 5 éléments, répertoriés en tant que “5V” :

- le volume : comme nous l’avons déjà évoqué plus haut, le Big Data représente en effet un volume de données conséquent – qui plus est, en constante augmentation ;

- la vitesse : la bonne réponse doit être apportée au bon moment et par l’intermédiaire du bon canal. C’est le rôle de l’intelligence artificielle et du machine learning, entre autres ;

- la variété : en référence à l’hétérogénéité des données traitées ;

- la véracité : par opposition au manque de fiabilité des contenus parfois partagés sur le net, qu’il est donc impératif de contrôler ;

- la valeur : autrement dit le petit “plus” apporté par ces métadonnées, qui permettront de répondre à des objectifs marketing et commerciaux.

Les tendances de 2021

L’ère du numérique et l’essor du digital ont logiquement induit une croissance continue et exponentielle du Big Data. À titre illustratif, selon une étude IBM réalisée en 2020, ⅔ des entreprises françaises disent explorer, voire déjà user de l’intelligence artificielle.

Comme nous l’avons vu précédemment, cet intérêt s’explique logiquement, en raison des multiples bénéfices que l’analyse de données est en mesure d’apporter aux acteurs de l’économie (gain de temps et optimisation des performances marketing et commerciales, notamment). Là où l’amélioration de l’expérience utilisateur (et sa satisfaction) est un avantage de taille, pour se démarquer de la concurrence.

Toutefois, il est également intéressant de noter que les principaux obstacles à l’adoption de tels systèmes résident dans le manque de connaissances et d’outils. De fait, selon Gartner, 40% des tâches de data science sont menées par des individus n’ayant justement pas de compétences spécifiques en la matière.

Comme souvent, dans le milieu de la technologie, le changement s’amorce cependant rapidement. Aussi voit-on peu à peu poindre de nouvelles professions à l’image du data scientist ou du data engineer. Ces data scientists, experts de cette science nouvelle qu’est la data analytics, ont ainsi vocation à s’approprier enfin cette masse complexe, afin d’en optimiser l’usage. Des perles rares, qui font d’ores et déjà la convoitise de nombreuses organisations. Affaire à suivre.

Vous avez besoin d’intégrer, de gérer et/ou d’analyser des données en masse propres à votre activité? Notre solution Datanalyz vous permet d’optimiser vos méthodes de travail et de reprendre le contrôle de votre entreprise. N’hésitez plus et contactez Elipce pour vous informer et découvrir la puissance de notre solution.